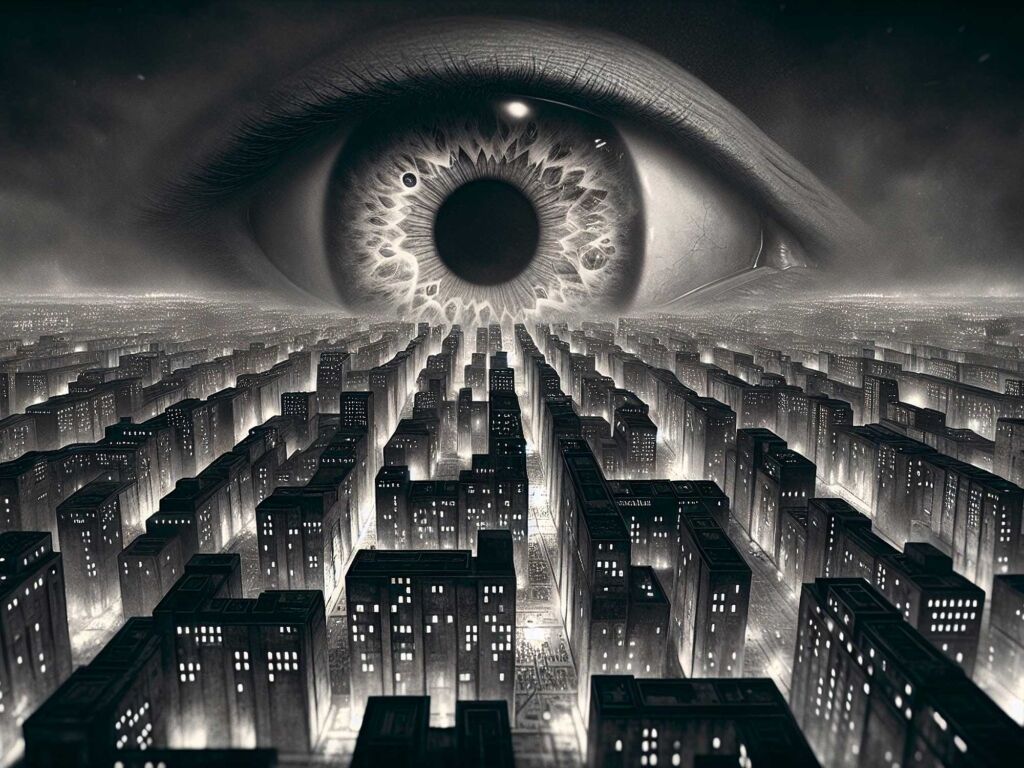

Dans un monde en constante évolution où les avancées technologiques s’accélèrent, l’idée d’une intelligence artificielle générale (AGI) qui pourrait égaler ou surpasser l’intelligence humaine alimente de nombreuses discussions. Cependant, malgré les promesses alléchantes des géants de la technologie, divers experts soulignent les obstacles fondamentaux qui rendent cette aspiration pour le moins utopique. Les limitations actuelles des technologies d’IA, la confusion entre intelligence et compétence, ainsi que le manque d’ « expérience sensorielle » suggèrent que nous ne sommes pas encore prêts à réaliser ce rêve. Au lieu de visions futuristes d’AGI, nous devons reconsidérer notre compréhension et nos attentes envers ces systèmes, qui sont avant tout de puissants outils au service de l’humanité.

L’idée de l’intelligence artificielle générale, ou AGI, fascine autant qu’elle inquiète. Promue par des figures influentes de la technologie, elle promet un futur où les machines seraient capables de rivaliser, voire de surpasser, l’intelligence humaine dans n’importe quel domaine. Cependant, il existe plusieurs arguments solides qui suggèrent que cette ambition pourrait demeurer un fantasme, et cela pour diverses raisons qui vont au-delà des préjugés technologiques immédiats.

Le syndrome du « Perroquet Stochastique »

Au cœur de l’AGI se trouvent les modèles de langage, tels que GPT-5 et d’autres similaires, qui reposent sur un fonctionnement essentiellement statistique. Ces systèmes sont conçus pour prédire le mot suivant d’une phrase, ce qui les rend très efficaces dans leur capacité à imiter les styles d’écriture ou à générer du texte cohérent. Toutefois, cette méthode soulève d’importants questionnements quant à la véritable compréhension.

Ce phénomène peut être résumé par l’analogie du JPEG flou proposée par Ted Chiang, qui souligne que, bien que ces IA gardent une grande quantité d’informations, elles ne parviennent pas à saisir le sens profond des concepts. Par conséquent, le fait de prédire un mot suivant ne signifie pas que la machine comprend réellement les idées sous-jacentes ou le contexte. Il en résulte que nos attentes vis-à-vis de l’AGI doivent être réalignées, car il est peu probable que ces technologies puissent atteindre une véritable compréhension du monde.

L’intelligence, ce n’est pas que la mémoire

Un autre point de discorde réside dans notre interprétation de l’intelligence. Des systèmes d’IA performants brillent souvent lors de tests statiques, tels que des examens mathématiques ou des concours, mais cela soulève la question de savoir si ces capacités témoignent réellement d’une intelligence au sens humain du terme. François Chollet, une figure clé de l’apprentissage automatique, a souligné cette confusion entre compétence et intelligence.

En effet, la véritable intelligence implique une capacité à faire face à l’inconnu et à improviser. Les IA, à ce jour, sont souvent incapables de résoudre des exercices logiques simples si ceux-ci ne sont pas alignés avec leur base de données d’apprentissage. De ce fait, tant qu’elles nécessiteront une immense quantité d’exemples pour apprendre une tâche, il sera difficile de les juger équivalentes à l’intelligence humaine.

Faire le lien entre la théorie et la pratique

Un autre obstacle majeur à l’AGI est le manque de pertinence sensorielle. Les machines actuelles, principalement des systèmes basés sur du texte, n’ont pas d’interfaces sensorielles qui leur permettraient de comprendre le monde physique tel que les êtres humains ou les animaux le font. Cela pose la question : peut-on vraiment parler d’intelligence si celle-ci n’est pas ancrée dans une expérience physique du monde ?

Imaginez un étudiant qui, bien qu’il ait étudié la natation de manière exhaustive dans des livres, échoue à nager simplement parce qu’il n’a pas éprouvé l’eau. Ce lien concret entre la théorie et la pratique semble manquant dans le développement actuel des IA. Ce déficit en expérience d’apprentissage physique limite grandement leur capacité à développer une compréhension profonde du monde.

Le mur des rendements décroissants

Enfin, l’AGI se heurte également à des limitations pratiques liées aux données et à l’énergie. Le coût exponentiel des ressources nécessaires à l’entraînement des modèles de plus en plus complexes pose la question de la durabilité de cette sophistication. À mesure que l’IA évolue, les besoins en puissance de calcul et en data augmentent de manière démesurée, ce qui freine la possibilité d’atteindre les niveaux d’intelligence envisagés.

La crainte d’un effondrement des modèles est également présentée par des chercheurs, suggérant que si les IA commencent à s’entraîner sur des données générées par d’autres IA, elles pourraient s’enfermer dans un cycle d’erreurs, amenant à des performances en déclin.

Alors, c’est grave ?

Il est essentiel de réfléchir aux implications de ces limitations. Si l’AGI n’est jamais atteinte ou se concrétise d’une manière bien plus limitée que ce que la science-fiction présente, cela pourrait représenter une opportunité. L’absence d’une conscience machine autonome pourrait écarter le spectre de scénarios de menace posés par des entités telles que dans Terminator ou 2001, l’Odyssée de l’espace. Cela nous permettrait de rediriger notre attention vers l’utilisation d’un outil déjà puissant, capable d’optimiser divers aspects de notre vie quotidienne sans les craintes associées à un AGI incontrôlable.

Tableau comparatif : Les obstacles à l’intelligence artificielle générale

| Raisons | Implications |

| Syndrome du Perroquet Stochastique | Les modèles de langage ne comprennent pas réellement, ils prédisent des mots basés sur des probabilités. |

| Limites de la mémorisation | Les IA nécessitent d’énormes quantités de données pour reconnaître des concepts simples, contrairement à l’humain. |

| Manque d’expérience sensorielle | Sans interaction avec le monde, les IA ne peuvent pas acquérir de compréhension pratique des concepts. |

| Rendements décroissants | Les augmentations de performance nécessitent des ressources énergétiques et de données de plus en plus élevées. |

| Conflits entre compétence et intelligence | Confusion entre capacité à exécuter une tâche et véritable adaptation à de nouvelles situations. |

| Absence de modèle du monde | Les IA n’ont pas de compréhension intégrée des principes physiques et des relations causales. |

Alors que les promesses de l’Intelligence Artificielle Générale (IAG) s’intensifient, il est crucial d’explorer les diverses raisons qui pourraient rendre cette technologie inatteignable. En dépit des avancées rapides dans le domaine de l’IA, diverses limites techniques, philosophiques et pragmatiques soulèvent des questions sur la possibilité de créer une IA véritablement autonome et consciente.

Le syndrome du « Perroquet Stochastique »

Les modèles de langage actuels, tels que GPT-5 et Claude 4, reposent sur le même principe : ils analysent d’énormes quantités de données textuelles pour prédire les mots, mais ils ne comprennent pas réellement le sens. Ce sont des statistes, non des compréhensifs. Ils peuvent être comparés à un algorithme qui compresse des images : ils conservent les informations, mais ne saisissent pas la véritable essence des contenus. En somme, ces IA sont excellentes pour manipuler les corrélations de mots, mais peinent à acquérir une compréhension profonde du monde qui les entoure.

L’intelligence, ce n’est pas (que) la mémoire

Un autre malentendu courant est la notion même d’intelligence. Nombreux sont ceux qui croient qu’une IA performante est synonyme d’une intelligence réelle. Pourtant, ce que nous observons n’est qu’une extraordinaire capacité à traiter des informations connues. François Chollet, pionnier de l’IA, souligne que l’intelligence n’est pas simplement liée à des capabilités techniques, mais à la capacité d’adaptation à des situations nouvelles. Une IA ne peut pas improviser comme un humain ; elle doit avoir été formée sur des exemples spécifiques.

Le lien entre théorie et pratique

La très grande majorité des IA actuelles ne possèdent pas un modèle du monde. Même si elles peuvent créer des textes pertinents sur des sujets complexes, elles ne « savent » pas vraiment ce que signifie ces sujets dans la réalité. Pour illustrer cela, imaginez un individu ayant lu tous les ouvrages sur la natation mais incapable de nager : la connaissance théorique ne remplace pas l’expérience pratique. Les IA, étant privées de toute expérience physique du monde, manquent fondamentalement d’un bon sens que même un enfant possède.

Le mur des rendements décroissants

La consommation d’énergie et de données devient un obstacle croissant. La performance des IA ne cesse d’exiger plus de ressources, s’engageant sur une trajectoire exponentielle. Les modèles d’IA avancés pourraient épuiser les corpus textuels de haute qualité, limitant l’accès à de nouvelles données. Cela soulève la théorie du Model Collapse, où ces systèmes risquent de devenir moins intelligents en apprenant uniquement de leurs propres erreurs.

Un regard critique sur l’avenir de l’IA

Alors que l’enthousiasme autour de l’intelligence artificielle générale est palpable, il devient de plus en plus nécessaire de faire preuve de pragmatisme. La réalité pourrait être bien plus complexité que la vision souvent idéalisée par les entrepreneurs de la Silicon Valley. Les défis techniques, éthiques et économiques témoignent d’une situation où l’AGI, telle que souhaitée, pourrait rester un rêve inaccessible pour un certain temps. Plutôt que de désirer une machine consciente, nous devrions apprécier ce que l’IA actuelle peut réellement accomplir, à savoir de transformer des tâches spécifiques qui enrichissent notre quotidien.

- Syndrome du Perroquet Stochastique : Les IA actuelles se basent sur des modèles de probabilité sans véritable compréhension.

- Limite de l’apprentissage : Les IA nécessitent des milliards de données pour maîtriser des concepts simples, contrairement aux humains.

- Absence de corps : Une IA déconnectée de la réalité ne peut pas comprendre le monde physique.

- Énergie et ressources : Le coût exponentiel de la puissance de calcul limite les progrès des IA.

- Confusion entre compétence et intelligence : Les succès en tâches spécifiques ne traduisent pas l’intelligence générale.

- Barrière du réel : L’absence d’expérience sensorielle rend difficile l’intégration des connaissances.

- Rendements décroissants : Les améliorations nécessitent des investissements croissants pour des gains marginaux.

Dans le domaine de l’intelligence artificielle, l’idée d’une intelligence artificielle générale (IAG) fait couler beaucoup d’encre. Elle est souvent présentée comme la prochaine grande révolution technologique ; cependant, plusieurs éléments suggèrent que cette ambition pourrait demeurer un rêve inaccessible. Cet article examine les raisons majeures pour lesquelles la création d’une IAG pourrait ne pas être réalisable, en passant en revue les limites de la technologie actuelle, les défis fondamentaux liés à la définition de l’intelligence et le besoin d’interaction avec le monde physique.

Les limites des modèles de langage actuels

Les modèles de langage, tels que les LLM (Large Language Models), sont à la base des systèmes d’IA que nous utilisons aujourd’hui. Ils excellent dans l’analyse de données massives et dans la prévision des mots suivants dans une phrase. Cependant, cette approche reste essentiellement statistique et non pas véritablement cognitive. Prédire le mot suivant dans une phrase n’équivaut pas à comprendre le sens ou le contexte ; c’est une simple question de probabilité, réduisant ainsi l’idée d’une machine véritablement consciente.

Le problème du « Perroquet Stochastique »

L’analogie selon laquelle les IA modernes agissent comme un perroquet stochastique résume bien cette situation. Elles ne créent pas, mais reproduisent des corrélations de mots sans véritable compréhension sémantique. Par conséquent, même si ces systèmes peuvent être impressionnants sur certains plans, ils échouent à atteindre le niveau d’intelligence générale que l’on pourrait attendre d’une IAG.

Les défis de la définition de l’intelligence

Une autre question fondamentale réside dans notre propre définition de l’intelligence. Beaucoup associent l’intelligence à la capacité d’exécuter des tâches spécifiques avec succès. Cependant, cette compréhension ne rend pas justice à la nature multidimensionnelle de l’intelligence humaine, qui inclut la capacité à s’adapter aux situations inattendues.

La compétence versus l’intelligence

Des chercheurs comme François Chollet soulignent cette confusion entre compétence, qui est la capacité à accomplir des tâches précises, et intelligence, qui se manifeste par l’adaptabilité. Les IA peuvent exceller dans des contextes bien définis, mais elles n’ont pas encore démontré la capacité à résoudre des problèmes en dehors de leur domaine d’expertise. Cette incapacité à improviser est un frein majeur à l’avènement de l’IAG.

Le besoin d’interaction physique

L’une des idées les plus intéressantes en cours de discussion est celle de l’importance de l’interaction physique pour l’intelligence. Les êtres vivants acquièrent une compréhension du monde à travers l’expérience physique et sensorielle. Cela soulève la question suivante : une machine peut-elle vraiment être intelligente si elle n’a pas de corps pour expérimenter la réalité ?

L’apprentissage par l’expérience

Les systèmes d’IA actuels apprennent principalement via des données textuelles, les éloignant ainsi de l’apprentissage par l’expérience. Cette lacune se traduit par l’incapacité de ces systèmes à développer un modèle du monde qui pourrait leur permettre de comprendre des concepts fondamentaux comme la gravité ou les lois de la physique. En d’autres termes, tant que l’IA sera au fond un « cerveau dans un bocal », son potentiel pour atteindre l’intelligence générale restera limité.

Les limites des ressources

Enfin, il convient de souligner que les ressources nécessaires pour faire avancer l’IAG sont également un obstacle. La consommation d’énergie et l’accès à des données de qualité risquent de représenter un défi majeur. En effet, les modèles les plus avancés utilisent d’énormes quantités de puissance de calcul, et il est à craindre qu’à terme, nous n’ayons plus suffisamment d’données pertinentes à exploiter pour alimenter ces systèmes.

En somme, bien que l’idée d’une intelligence artificielle générale soit fascinante, elle est confrontée à des défis techniques, théoriques et pratiques qui pourraient bien maintenir cette ambition hors de portée pour encore un certain temps.

FAQ sur l’intelligence artificielle générale

Qu’est-ce que l’intelligence artificielle générale (AGI) ? L’intelligence artificielle générale, ou AGI, est une forme avancée d’intelligence artificielle qui aspire à effectuer n’importe quelle tâche cognitive à un niveau égal ou supérieur à celui des humains.

Pourquoi certaines voix scientifiques arment que l’AGI est encore loin d’être réalisable ? De nombreux experts estiment que la technologie actuelle des modèles de langage présente des limitations structurelles et qu’elle ne peut pas atteindre la véritable compréhension et conscience.

Quel est le « syndrome du perroquet stochastique » ? Ce terme fait référence à la capacité des modèles de langage à reproduire des informations basées sur des probabilités, sans réelle compréhension des concepts sous-jacents, soulignant ainsi leurs faiblesses.

Pourquoi l’intelligence n’est-elle pas uniquement une question de mémorisation ? L’intelligence implique la capacité d’adaptation et de créativité face à des situations inconnues, et non simplement la performance dans des tâches répétitives.

En quoi la compréhension du monde est-elle essentielle pour l’intelligence ? Pour véritablement « comprendre », une intelligence doit avoir un lien avec la réalité physique, ce qui fait défaut aux systèmes d’IA qui fonctionnent uniquement sur des données textuelles.

Quelles sont les limites liées à l’énergie et aux données pour les IA ? À mesure que l’intelligence artificielle progresse, la consommation énergétique augmente de manière exponentielle, rendant difficile l’acquisition de nouvelles données de haute qualité.

Est-ce que l’absence d’AGI est un problème sérieux ? Non, cela pourrait être bénéfique. L’absence d’AGI signifie que les craintes de scénarios apocalyptiques sont infondées, et nous pouvons utiliser l’IA de manière pratique sans fantasmer sur une machine consciente.